Blog

AI模型競逐頂尖,基準評估面臨挑戰:使用者需求與實際表現相遇

AI模型競逐頂尖,基準評估面臨挑戰:使用者需求與實際表現相遇

March 8, 2024

重點摘要:

- 新創公司Anthropic和競爭對手Inflection AI相繼推出新的生成式AI模型,宣稱在性能和品質上均有突破。

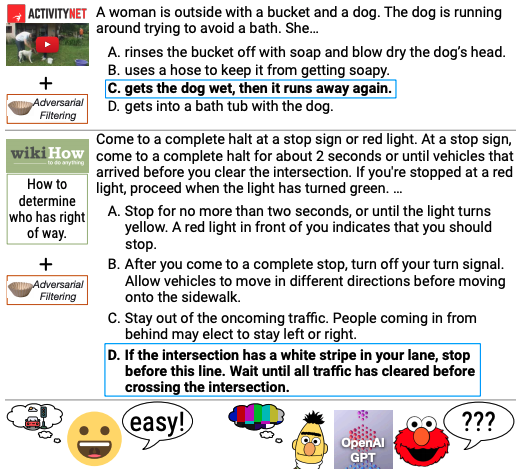

- AI模型評估基準存在挑戰,主要是因為現有基準不足以捕捉真實使用者與模型的互動方式,導致性能評估與實際應用之間存在落差。

- 專家指出,修復基準問題的關鍵在於結合人工評估和自動化評估,以更好地反映模型在實際情境中的表現。

新聞內文:

週二,新創公司Anthropic發布了一系列生成式AI模型,聲稱其實現了最佳性能。僅幾天之後,競爭對手Inflection AI推出了一款模型,它聲稱在品質上接近一些最強大的模型,包括OpenAI的GPT-4。Anthropic和Inflection絕不是第一家聲稱其模型在某些客觀指標上超越競爭對手的AI公司。Google在其Gemini模型推出時就提出了同樣的觀點,OpenAI也是如此,它曾表示GPT-4及其前作GPT-3、GPT-2和GPT-1也具有這種性能。這樣的例子還有很多。

但是,他們所謂的指標是指什麼呢?當供應商表示某個模型實現了最先進的性能或質量時,這究竟意味著什麼?或者更直接地說:技術上「表現」優於其他模型的模型是否會在實際中感覺到改進?

對於最後一個問題,可能性不大。問題在於AI公司用來量化模型優勢和劣勢的基準。

專門性指標

如今,用於評估AI模型的最常用基準(特別是像OpenAI的ChatGPT和Anthropic的Claude這樣的聊天機器人驅動模型)在捕捉平均人與被測試的模型的互動方式方面做得很差。例如,Anthropic在其最近的公告中引用的一個基準,GPQA(研究生級別的Google免疫問答基準),包含了數百個博士級別的生物學、物理學和化學問題。然而,大多數人使用聊天機器人的任務是回覆郵件、撰寫求職信和談論他們的感受。AI研究非盈利組織Allen Institute for AI的科學家Jesse Dodge表示,該行業已經達到了「評估危機」。

Dodge在接受TechCrunch的採訪時表示:「基準通常是靜態的,並且狹窄地專注於評估單一能力,例如模型在單一領域的事實性,或者其解決數學推理多選問題的能力」。「許多用於評估的基準都是三年以上的,當時AI系統主要用於研究,並且沒有很多真實使用者。此外,人們以許多方式使用生成式AI,他們非常有創意」。

錯誤和其他缺陷

除了與用例不匹配之外,還有一個問題,即一些基準是否確實衡量了它們所聲稱的衡量指標。對HellaSwag的分析發現超過三分之一的測試問題包含打字錯誤和「無意義」的文字。此外,MMLU(即「大規模多任務語言理解」)是一個基準,被Google、OpenAI和Anthropic等供應商指出,以證明其模型可以透過死記硬背解決問題。

Widder說道:「像MMLU這樣的基準更多是關於死記硬背和將兩個關鍵詞聯繫在一起」。「我可以很快找到一篇相關的文章並回答問題,但這並不意味著我理解了因果機制,或者能夠利用對這種因果機制的理解來實際推理並解決新的和複雜的問題。模型也無法」。

修復問題

那麼,基準有問題。但能修復嗎?Dodge認為可以,透過更多的人力介入。她說:「在這裡,正確的前進道路是將評估基準與人類評估相結合」,「以一個真實使用者的查詢作為提示,然後聘請一個人來評價回答的品質」。

至於Widder,他不太樂觀,認為即使修復了更明顯的錯誤,如打字錯誤,如今的基準也不能提高到對絕大多數生成式AI模型使用者有用的程度。相反地,他認為模型的測試應該專注於這些模型的下游影響,以及這些影響,無論是好是壞,對受影響的人是否被認為是可取的。

他說:「我會問我們希望AI模型能夠在哪些具體的情境中使用,並評估它們是否能夠在這樣的情境中成功」。「同時,我們也希望這個過程涉及評估我們是否應該在這樣的情境中使用AI」。

新聞原址: https://techcrunch.com/2024/03/07/heres-why-most-ai-benchmarks-tell-us-so-little/