Blog

Nvidia準備用下一代Grace Hopper超級晶片推動人工智慧向前邁進。

Nvidia準備用下一代Grace Hopper超級晶片推動人工智慧向前邁進。

August 9, 2023

今天是Nvidia的忙碌新聞日,因為這家人工智慧領導者在年度SIGGRAPH大會上揭開了一系列新發展的面紗。

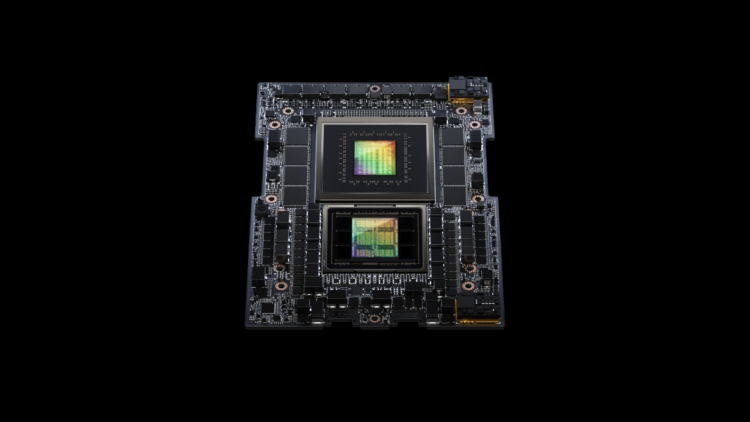

在硬體方面,該公司最大的發展之一是宣布新版本的GH200 Grace Hopper平台,配備了下一代HBM3e記憶體技術。今天宣布的GH200是對今年5月在台灣Computex展覽上宣布的現有GH200晶片的更新。

Nvidia創始人兼首席執行官Jensen Huang在SIGGRAPH的主題演講中說:“我們最近幾個月前宣布了Grace Hopper,今天我們宣布我們將對它進行提升。”

新GH200內部的內容

Grace Hopper超級晶片自2021年以來一直是Nvidia首席執行官的熱門話題,當時該公司透露了初步細節。

超級晶片基於Arm架構,該架構在移動設備中被廣泛使用,並與Intel和AMD的基於x86的晶片競爭。Nvidia稱其為“超級晶片”,因為它將基於Arm的Nvidia Grace CPU與Hopper GPU架構相結合。

隨著GH200的新版本,Grace Hopper超級晶片得到了世界上最快記憶體:HBM3e的提升。根據Nvidia的說法,HBM3e記憶體比GH200當前一代內部的HBM3技術快50%。

Nvidia還聲稱,HBM3e記憶體將使下一代GH200的AI模型運行速度比當前模型快3.5倍。

Nvidia的超大規模和高性能計算副總裁兼總經理Ian Buck在與記者和分析師的會議上說:“我們對這款新的GH200感到非常興奮。它將配備141千兆字節的HBM3e記憶體。” “HBM3e不僅增加了與我們的GPU相連的記憶體的容量和數量,而且速度要快得多。”

更快的晶片意味著更快,更大的AI應用推理和訓練

Nvidia不僅製造更快的晶片,還在新的伺服器設計中進行了擴展。

Buck表示,Nvidia正在開發一個新的雙GH200為基礎的Nvidia MGX伺服器系統,將整合兩個下一代Grace Hopper超級晶片。他解釋說,新的GH200將與Nvidia的互連技術NVLink相連接。

在新的雙GH200伺服器中使用NVLink,系統中的CPU和GPU將通過完全一致的記憶體互連相連接。

Buck說:“CPU可以看到其他CPU的記憶體,GPU可以看到其他GPU的記憶體,當然,GPU也可以看到CPU的記憶體。” “因此,結合超大超級GPU可以作為一個整體運作,提供8千兆浮點運算的計算性能和282千兆字節的HBM3e記憶體,共144個Grace CPU核心。”

雖然新的Nvidia Grace Hopper超級晶片非常快,但在實際用於生產用途之前還需要一些時間。預計下一代GH200將在2024年第二季度推出。

新聞原址: https://venturebeat.com/ai/nvidia-set-to-hop-ai-forward-with-next-gen-grace-hopper-superchip/

在硬體方面,該公司最大的發展之一是宣布新版本的GH200 Grace Hopper平台,配備了下一代HBM3e記憶體技術。今天宣布的GH200是對今年5月在台灣Computex展覽上宣布的現有GH200晶片的更新。

Nvidia創始人兼首席執行官Jensen Huang在SIGGRAPH的主題演講中說:“我們最近幾個月前宣布了Grace Hopper,今天我們宣布我們將對它進行提升。”

新GH200內部的內容

Grace Hopper超級晶片自2021年以來一直是Nvidia首席執行官的熱門話題,當時該公司透露了初步細節。

超級晶片基於Arm架構,該架構在移動設備中被廣泛使用,並與Intel和AMD的基於x86的晶片競爭。Nvidia稱其為“超級晶片”,因為它將基於Arm的Nvidia Grace CPU與Hopper GPU架構相結合。

隨著GH200的新版本,Grace Hopper超級晶片得到了世界上最快記憶體:HBM3e的提升。根據Nvidia的說法,HBM3e記憶體比GH200當前一代內部的HBM3技術快50%。

Nvidia還聲稱,HBM3e記憶體將使下一代GH200的AI模型運行速度比當前模型快3.5倍。

Nvidia的超大規模和高性能計算副總裁兼總經理Ian Buck在與記者和分析師的會議上說:“我們對這款新的GH200感到非常興奮。它將配備141千兆字節的HBM3e記憶體。” “HBM3e不僅增加了與我們的GPU相連的記憶體的容量和數量,而且速度要快得多。”

更快的晶片意味著更快,更大的AI應用推理和訓練

Nvidia不僅製造更快的晶片,還在新的伺服器設計中進行了擴展。

Buck表示,Nvidia正在開發一個新的雙GH200為基礎的Nvidia MGX伺服器系統,將整合兩個下一代Grace Hopper超級晶片。他解釋說,新的GH200將與Nvidia的互連技術NVLink相連接。

在新的雙GH200伺服器中使用NVLink,系統中的CPU和GPU將通過完全一致的記憶體互連相連接。

Buck說:“CPU可以看到其他CPU的記憶體,GPU可以看到其他GPU的記憶體,當然,GPU也可以看到CPU的記憶體。” “因此,結合超大超級GPU可以作為一個整體運作,提供8千兆浮點運算的計算性能和282千兆字節的HBM3e記憶體,共144個Grace CPU核心。”

雖然新的Nvidia Grace Hopper超級晶片非常快,但在實際用於生產用途之前還需要一些時間。預計下一代GH200將在2024年第二季度推出。

新聞原址: https://venturebeat.com/ai/nvidia-set-to-hop-ai-forward-with-next-gen-grace-hopper-superchip/