Blog

Stability AI 進一步升級新的圖像生成技術,新的SD XL 1.0 模型提供更佳的圖片生成!

Stability AI 進一步升級新的圖像生成技術,新的SD XL 1.0 模型提供更佳的圖片生成!

July 28, 2023

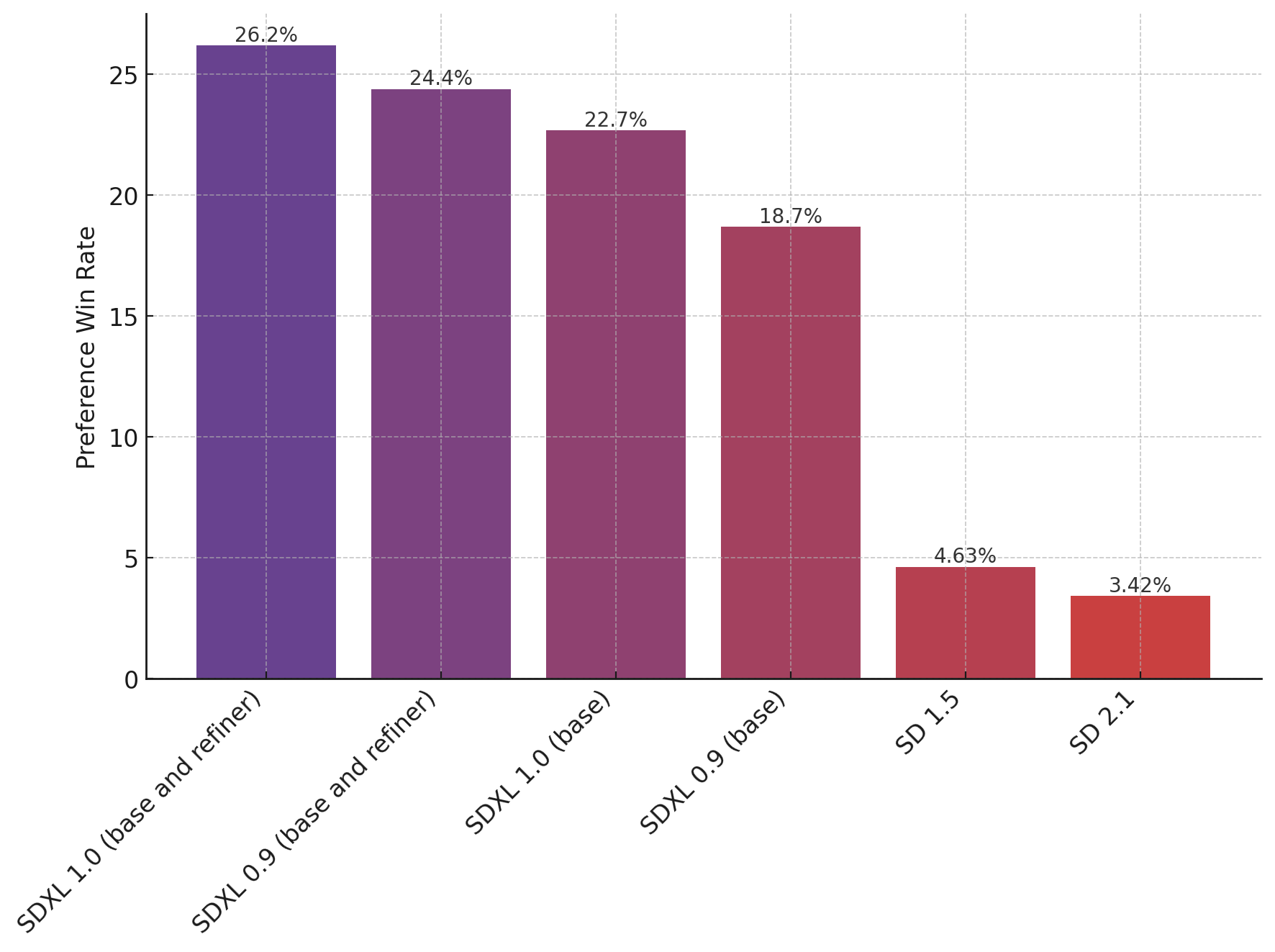

Stable Diffusion XL(SDXL)1.0是來自Stability AI的最新、尖端的文字至影像生成模型。此次釋出是Stability AI對於提升其能力並在面對像Midjourney和Adobe這樣的競爭對手(Adobe最近進入該領域,並推出了Firefly服務)時公開該模型的努力。

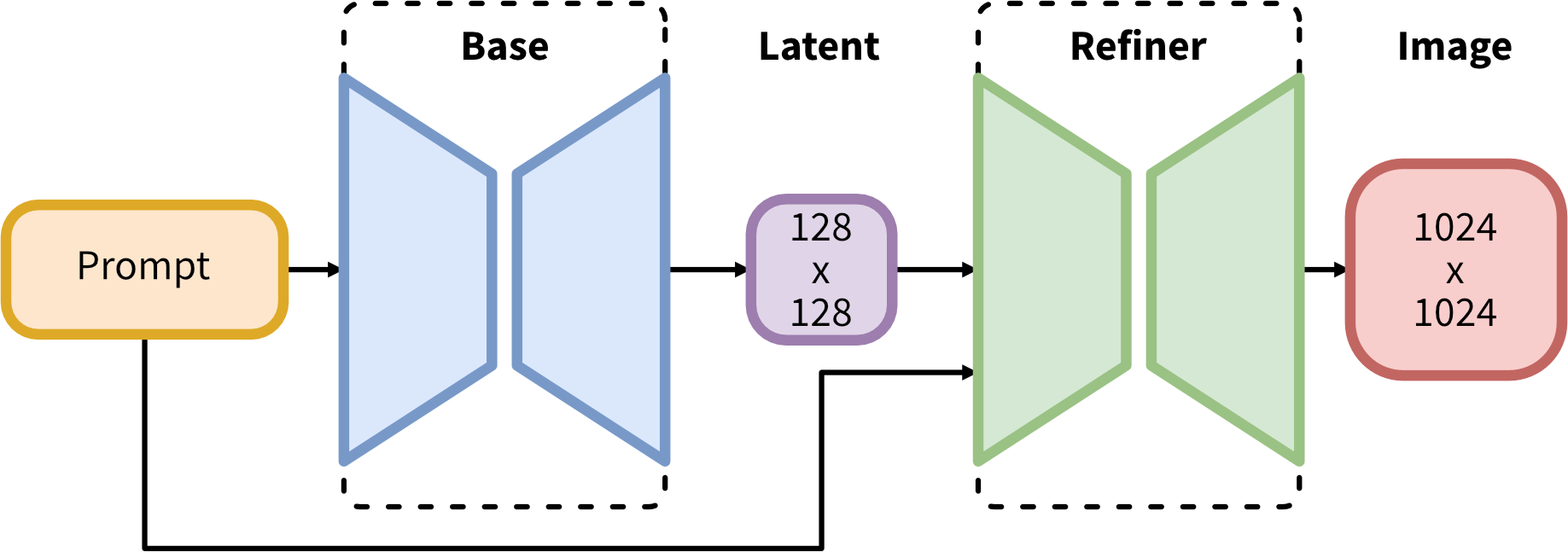

自六月以來,Stability AI就透過僅限研究的版本來預覽SDXL 1.0的能力,以顯示該模型的強大。該公司宣稱,其中一個改善點是改進的影像細化流程,相比以前的Stable Diffusion模型能生成更豐富的色彩、燈光和對比度。SDXL 1.0也引入了一個微調特性,讓使用者可以透過較少的創建高度自定義的影像。

SDXL 1.0模型是透過一種高度優化的訓練方式開發出來的,該方式受益於擁有35億參數的基礎模型。Stability AI將它定位為一個穩固的基礎模型,該公司預期會看到一個以此為基礎建立的工具和能力的生態系統。

Stability AI的CEO Emad Mostaque對VentureBeat說:“基礎模型非常有趣,他們就像Minecraft的版本,一個完整的修改社區就此出現,你在Stable Diffusion社區中看到了那種豐富性。但你需要有一個非常穩固的基礎才能建立。”

SDXL 1.0如何改善Stable Diffusion的微調與ControlNet

以文字至影像生成取得最佳可能的影像通常是一個反覆的過程,SDXL 1.0的目標就是要讓這一切變得更簡單。

Mostaque說:“用於微調的影像數量大幅降低了,現在只需要五到十張影像,你就能很快地微調出一個驚人的模型。”

幫助實現SDXL 1.0更容易的微調和改進的構圖的關鍵創新之一就是稱為“ControlNet”的方法。斯坦福大學的研究論文在今年初詳細說明了這種技術。Mostaque解釋說,例如,ControlNet可以讓輸入像骷髏圖這樣的圖像,然後將該影像映射到基礎擴散噪音基礎結構,以創建更高度的準確度和控制。

SDXL 1.0參數增加的重要性

Mostaque評論說,一個引發生成AI繁榮的關鍵因素是擴大規模,即增加參數數量,產生更多的特性和知識。他說,基礎SDXL 1.0模型中的35億參數造就了更高的整體準確性。

他說:“你正在教模型各種事情,並且更深入地教它。參數數量實際上很重要 — 它了解的概念越多,它對這些事情的了解就越深。”

雖然SDXL 1.0有更多參數,但使用者並不需要輸入長的標記或提示以獲得更好的結果,這通常是文字生成模型的情況。Mostaque說,與SDXL 1.0相比,使用者可以提供複雜的多部分指示,現在比先前的模型,僅需要更少的文字,就能生成準確的影像。對比先前的Stable Diffusion模型,使用者通常需要更長的文字提示。

他解釋說:“你不需要這個模型來做那些複雜的輸入,因為我們與我們的合作夥伴一起做了0.9版本的強化學習與人類反饋(RLHF)階段。”

SDXL 1.0基礎模型今天起已經在多個地方提供服務,包括Amazon Bedrock和Amazon SageMaker Jumpstart。

新聞原址: Stability AI launches new Stable Diffusion base model for better image composition | VentureBeat