Blog

企業訓練AI的成功秘訣:讓它變得更容易理解,而且值得信賴

企業訓練AI的成功秘訣:讓它變得更容易理解,而且值得信賴

July 18, 2023

人工智慧的潛力終於開始浮現。無論是醫療保健還是金融科技,各行各業的公司都在爭先恐後地實施大型語言模型(LLMs)和其他類型的機器學習系統,以補充他們的工作流程,並節省時間去處理其他更迫切或更高價值的任務。然而,這一切的進展速度如此之快,以至於許多人可能忽略了一個關鍵的問題:我們如何知道做出決策的機器不會傾向於做出錯誤的判斷?

以醫療保健領域為例,AI具有預測臨床結果或發現藥物的潛力。如果模型在這樣的場景中走錯方向,它可能會提供可能最終傷害人的結果,甚至更糟。沒有人會希望這樣。

這就是人工智慧可解釋性的概念出現的地方。它是理解機器學習系統做出的決策或預測背後的原因的過程,並將該信息變得易於理解,以供決策者和其他有權做出變更的相關方了解。

當做對的時候,它可以幫助團隊發現意外的行為,使他們在問題造成真正的損害之前就消除這些問題。

但這絕非易事。

首先,讓我們了解為什麼人工智慧可解釋性是必須的

隨著像醫療保健這樣的關鍵行業繼續部署最少人工監督的模型,人工智慧的可解釋性已成為確保系統透明度和責任感的重要因素。

透明度確保人類操作員可以理解機器學習系統的基本原理,並對其進行偏見、準確性、公平性以及對道德準則的遵守進行審核。與此同時,責任感確保了及時解決確定的差距。後者尤其重要,在像自動信用評分、醫學診斷和自動駕駛等高風險領域,AI的決策可能會有深遠的後果。

除此之外,AI可解釋性也有助於建立對AI系統的信任和接受。基本上,當個人可以理解並驗證機器做出的決定背後的原因時,他們更有可能信任其預測和答案,從而導致廣泛的接受和採用。更重要的是,當有解釋可用時,解決歧視或數據使用等道德和法律遵從問題會更容易。

AI可解釋性並非易事

雖然AI可解釋性的好處顯而易見,但現代機器學習模型的復雜性和不透明性使得這成為一個巨大的挑戰。

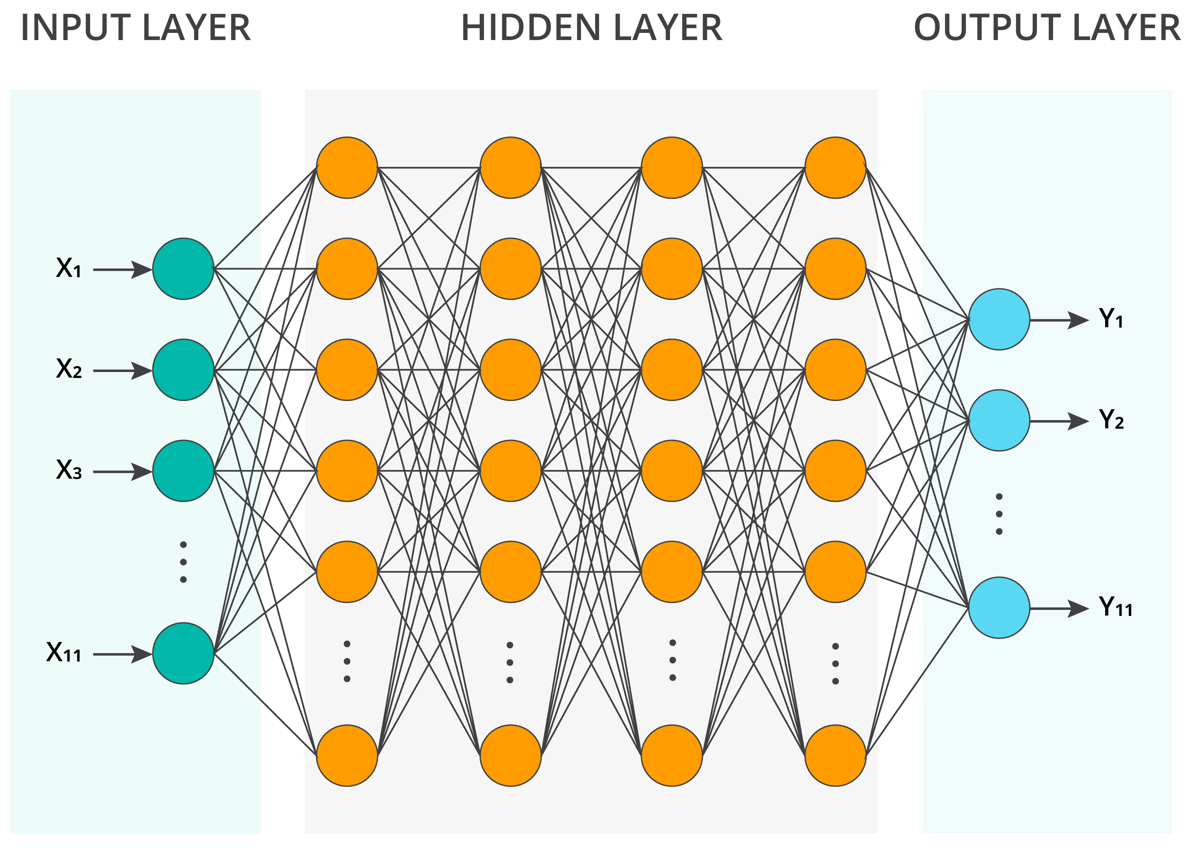

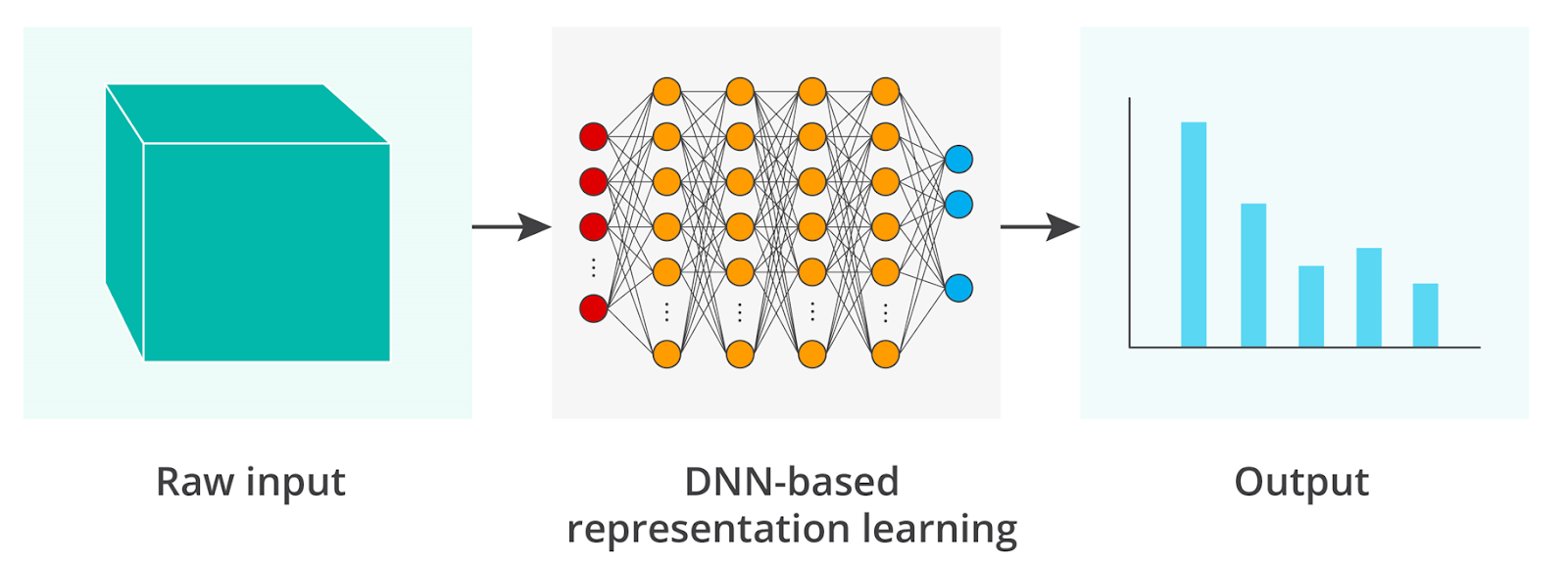

今天大多數高端的AI應用都使用深度神經網路(DNNs),該網路使用多個隱藏層來啟用可重用的模組化功能,並提高在利用參數和學習輸入和輸出之間的關係方面的效率。DNNs輕易地比具有相同參數和數據的淺層神經網路產生更好的結果 - 這些網路通常用於如線性回歸或特徵提取等任務。

然而,由數千甚至數百萬個參數和多層結構構成的這種架構使DNNs變得高度不透明,使得難以理解特定輸入如何促成模型的決策。相比之下,具有簡單架構的淺層網路具有很高的可解釋性。

那麼,我們可以做什麼?

為了找到一些折衷的方法,研究人員正在開發基於規則並具有可解釋性的模型,如決策樹和線性模型,這些模型將透明度作為優先考慮的因素。這些模型提供明確的規則和易於理解的表示,使人類操作員能夠解釋他們的決策過程。然而,它們仍然缺乏更先進模型的復雜性和表現力。

作為一種替代方案,事後可解釋性,其中一種在模型被訓練之後應用工具來解釋模型決策的方法,可能會派上用場。目前,像LIME(本地可解釋的模型無關的解釋)和SHAP(SHapley Additive exPlanations)這樣的方法可以通過近似特徵的重要性或產生局部解釋來提供對模型行為的見解。它們有可能在復雜模型和可解釋性之間搭起橋樑。

研究人員也可以選擇混合方法,這種方法結合了可解釋模型和黑盒模型的優點,實現了可解釋性和預測性能之間的平衡。這些方法利用與模型無關的方法,如LIME和替代模型,提供解釋,而不會損害底層複雜模型的準確性。

AI可解釋性:巨大的可能性

未來,AI的可解釋性將繼續演變,並在塑造負責任和值得信賴的AI生態系統中發揮關鍵作用。

這種演變的關鍵在於廣泛採用與模型無關的解釋性技術(應用於任何機器學習模型,無論其底層架構如何)以及訓練和解釋過程的自動化。這些進步將使用戶能夠理解並信任高性能的AI算法,而不需要廣泛的技術專長。然而,同時,平衡自動化的好處和道德考慮以及人類監督同樣重要。

最後,隨著模型訓練和解釋變得更加自動化,機器學習專家的角色可能會轉移到其他領域,如選擇正確的模型,實施精確的特徵工程,並根據可解釋性的見解做出明智的決策。

他們仍然存在,只是不再參與訓練或解釋模型。

新聞原址: https://venturebeat.com/ai/the-secret-to-enterprise-ai-success-make-it-understandable-and-trustworthy/

以醫療保健領域為例,AI具有預測臨床結果或發現藥物的潛力。如果模型在這樣的場景中走錯方向,它可能會提供可能最終傷害人的結果,甚至更糟。沒有人會希望這樣。

這就是人工智慧可解釋性的概念出現的地方。它是理解機器學習系統做出的決策或預測背後的原因的過程,並將該信息變得易於理解,以供決策者和其他有權做出變更的相關方了解。

當做對的時候,它可以幫助團隊發現意外的行為,使他們在問題造成真正的損害之前就消除這些問題。

但這絕非易事。

首先,讓我們了解為什麼人工智慧可解釋性是必須的

隨著像醫療保健這樣的關鍵行業繼續部署最少人工監督的模型,人工智慧的可解釋性已成為確保系統透明度和責任感的重要因素。

透明度確保人類操作員可以理解機器學習系統的基本原理,並對其進行偏見、準確性、公平性以及對道德準則的遵守進行審核。與此同時,責任感確保了及時解決確定的差距。後者尤其重要,在像自動信用評分、醫學診斷和自動駕駛等高風險領域,AI的決策可能會有深遠的後果。

除此之外,AI可解釋性也有助於建立對AI系統的信任和接受。基本上,當個人可以理解並驗證機器做出的決定背後的原因時,他們更有可能信任其預測和答案,從而導致廣泛的接受和採用。更重要的是,當有解釋可用時,解決歧視或數據使用等道德和法律遵從問題會更容易。

AI可解釋性並非易事

雖然AI可解釋性的好處顯而易見,但現代機器學習模型的復雜性和不透明性使得這成為一個巨大的挑戰。

今天大多數高端的AI應用都使用深度神經網路(DNNs),該網路使用多個隱藏層來啟用可重用的模組化功能,並提高在利用參數和學習輸入和輸出之間的關係方面的效率。DNNs輕易地比具有相同參數和數據的淺層神經網路產生更好的結果 - 這些網路通常用於如線性回歸或特徵提取等任務。

然而,由數千甚至數百萬個參數和多層結構構成的這種架構使DNNs變得高度不透明,使得難以理解特定輸入如何促成模型的決策。相比之下,具有簡單架構的淺層網路具有很高的可解釋性。

總的來說,通常在可解釋性和預測性能之間存在權衡。如果您選擇高性能模型,如DNNs,系統可能無法提供透明度,而如果您選擇一些簡單且可解釋的東西,如淺層網路,則結果的準確性可能不夠理想。

在全球的研究人員和從業人員中,找到兩者之間的平衡仍然是一個挑戰,尤其是考慮到缺乏標準化的可解釋性技術。

在全球的研究人員和從業人員中,找到兩者之間的平衡仍然是一個挑戰,尤其是考慮到缺乏標準化的可解釋性技術。

那麼,我們可以做什麼?

為了找到一些折衷的方法,研究人員正在開發基於規則並具有可解釋性的模型,如決策樹和線性模型,這些模型將透明度作為優先考慮的因素。這些模型提供明確的規則和易於理解的表示,使人類操作員能夠解釋他們的決策過程。然而,它們仍然缺乏更先進模型的復雜性和表現力。

作為一種替代方案,事後可解釋性,其中一種在模型被訓練之後應用工具來解釋模型決策的方法,可能會派上用場。目前,像LIME(本地可解釋的模型無關的解釋)和SHAP(SHapley Additive exPlanations)這樣的方法可以通過近似特徵的重要性或產生局部解釋來提供對模型行為的見解。它們有可能在復雜模型和可解釋性之間搭起橋樑。

研究人員也可以選擇混合方法,這種方法結合了可解釋模型和黑盒模型的優點,實現了可解釋性和預測性能之間的平衡。這些方法利用與模型無關的方法,如LIME和替代模型,提供解釋,而不會損害底層複雜模型的準確性。

AI可解釋性:巨大的可能性

未來,AI的可解釋性將繼續演變,並在塑造負責任和值得信賴的AI生態系統中發揮關鍵作用。

這種演變的關鍵在於廣泛採用與模型無關的解釋性技術(應用於任何機器學習模型,無論其底層架構如何)以及訓練和解釋過程的自動化。這些進步將使用戶能夠理解並信任高性能的AI算法,而不需要廣泛的技術專長。然而,同時,平衡自動化的好處和道德考慮以及人類監督同樣重要。

最後,隨著模型訓練和解釋變得更加自動化,機器學習專家的角色可能會轉移到其他領域,如選擇正確的模型,實施精確的特徵工程,並根據可解釋性的見解做出明智的決策。

他們仍然存在,只是不再參與訓練或解釋模型。

新聞原址: https://venturebeat.com/ai/the-secret-to-enterprise-ai-success-make-it-understandable-and-trustworthy/